这两天的deepseek-r1可以说是如日中天。优秀的质量水平和低廉的训练成本搅动了整个AI界。在面对突然涌入的巨大流量以及DDOS攻击下,deepseek的官方服务器已经不堪重负,为了优先保障网页端的使用体验,所有API的服务都暂时停止了。对我的使用产生极大的困扰。好在r1有不少蒸馏的小模型,可以部署到本地,这样在低精度环境就可以无成本的使用。这里顺便做一个本地部署的教程,有兴趣的朋友可以尝试。

部署环境

Windows10

I7 4710MQ

内存 16G

可以看到这个配置非常的低,这是一个十年前的笔记本。经过测试,这个配置可以流畅的运行deepseek-r1 1.5B以及较为流畅的运行deepseek-r1 7B模型。这让我非常的意外,所以只要你的电脑高于这个配置,特别是有一张不错的显卡的话,推荐直接7B起步!体验会好很多。

安装ollama

点击➔Ollama 进官网下载进行安装,直接默认就行。

下载完成后 任务栏右侧图标区域会出现一个ollama图标。浏览器输入127.0.0.1:11434提示Ollama is running代表安装成功。

拉取deepseek-r1模型

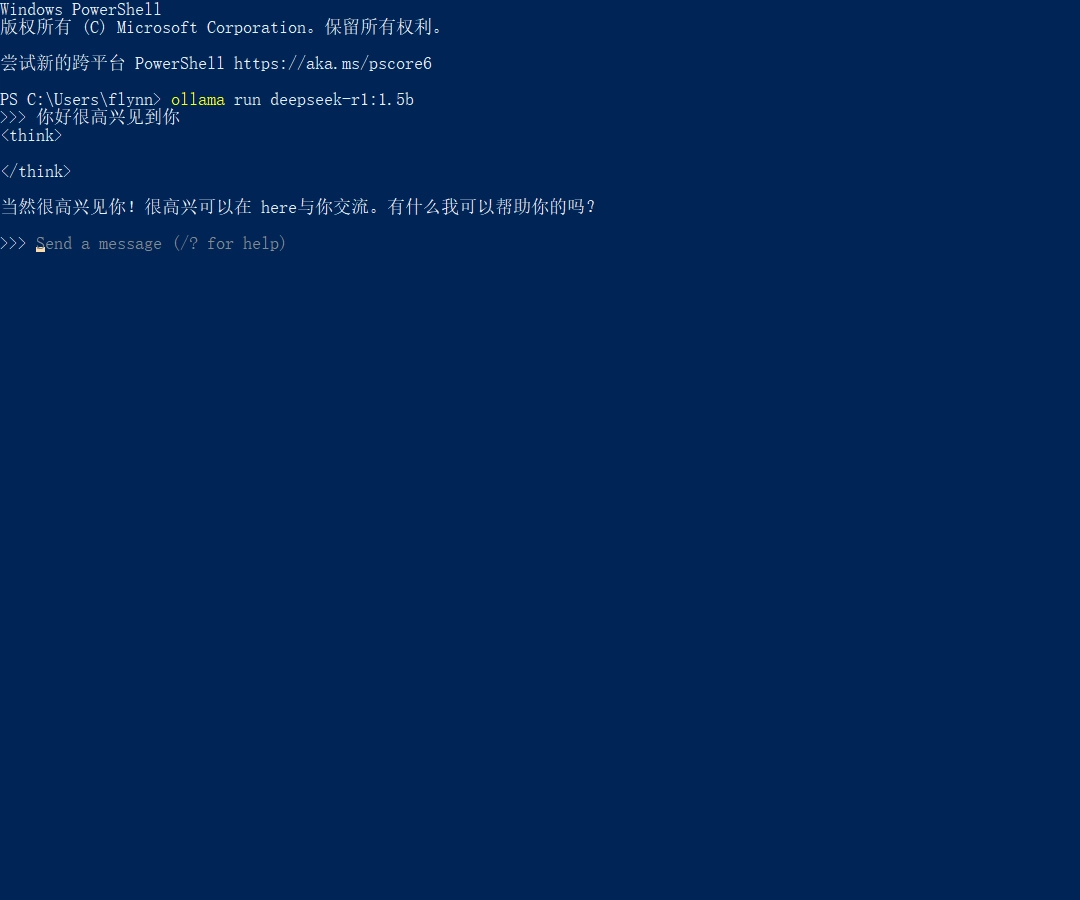

ollama安装成功后点Windows开始按钮打开powershell 输入以下命令

ollama run deepseek-r1:1.5b就可自动拉取安装deepseek-r1:1.5b模型。如果需要拉取7B 或者其他更大的模型 修改冒号后面的数字即可。如果你拥有12G以上的显存可以尝试14B(140亿参数)

拉取完成后出现Send a message字样就说明你已经成功在本地部署了deepseek-r1模型 直接在命令行里输入你的问题就可与deepseek-r1进行交互。

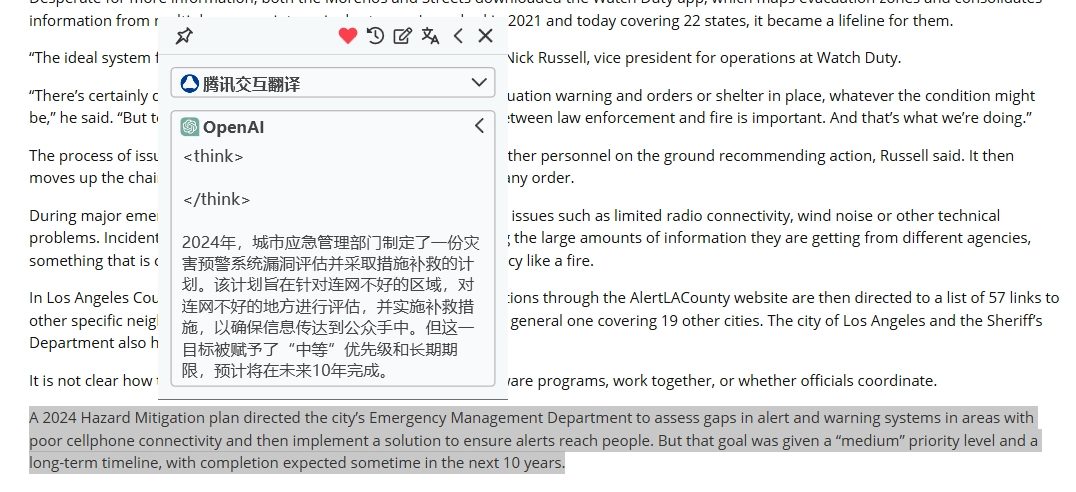

第三方调用本地部署的deepseek-r1模型

你可以通过下载➔Cherry Studio等类似的的LLM应用来调用你部署的deepseek模型。这里我使用quicker调用1.5B模型做了一个本地的翻译工具。参考设置如下

AI模型根据你部署的具体参数调整。 API地址是ollama默认地址 http://127.0.0.1:11434 API Key留空。其他软件调用基本一样。

翻译质量取决于你部署的模型参数。参数越大质量越好~其他应用场景也是如此。 另外ollama官网的models页面还有包括Qwen在内的其他开源模型。部署方法和deepseek是一样的,有兴趣的可以自行研究一下~